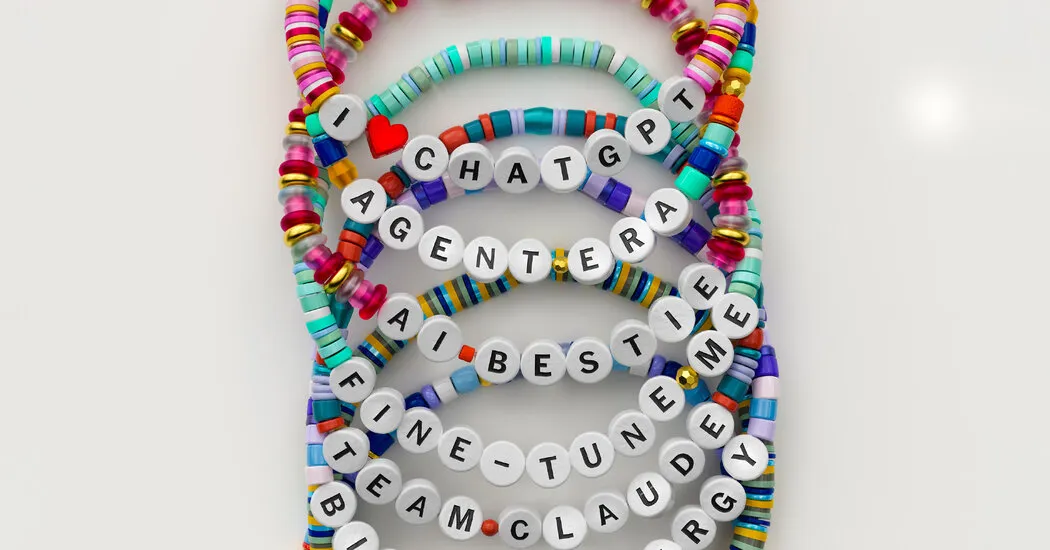

نظر | A.I. مدل ها برای محبت شما رقابت می کنند

وقتی OpenAI در اواخر سال 2022 چت ربات هوش مصنوعی پیشگام ChatGPT را منتشر کرد، هیچ کس در این شرکت انتظار زیادی نداشت. تلاشهای قبلی برای مدلهای زبانی با مصرفکننده منجر به بیتفاوتی یا حتی خصومت آشکار شده بود. نیک تورلی، مدیر پروژه ChatGPT، تصور کرد که این یک ماه طول خواهد کشید. او اخیراً به من گفت: «تمام تز ChatGPT این بود که یک نسخه نمایشی یادگیری است که ما آن را متوقف میکنیم، و سپس از آنچه یاد گرفتهایم برای ساختن محصول واقعی استفاده میکنیم.

در عوض ChatGPT شاید به موفقترین محصول مصرفی در تاریخ تبدیل شده است. در مدت کمی بیش از سه سال، 800 میلیون کاربر فعال هفتگی جمع آوری کرده است. سریعتر از Facebook، سریعتر از Google - در واقع سریعتر از هر سرویس دیگری که آماری برای آن وجود دارد، رشد کرده است.

موفقیت ChatGPT تا حدی به دلیل قدرت ترانسفورماتور از پیش آموزش دیده مولد (GPT در نام)، نوع خاصی از A.I است. که می تواند مقادیر زیادی متن را جذب کند و یاد بگیرد که آن را چند حرف در یک زمان بازتولید کند. اما این تنها بخشی از داستان است - و همانطور که OpenAI کشف کرد، شاید حتی مهمترین بخش هم نباشد. در حالت خام، خروجی GPT ها می تواند عجیب و غریب باشد. تنها پس از مرحله دوم "پس از آموزش" است که A.I. برای تعامل انسانی مناسب است. در حالی که موتورهایی که ChatGPT را به کار میبرند، غیرقابل انکار هستند، اما چیزی که باعث موفقیت محصول شده است، قابلیتهای آن نیست. این شخصیت ChatGPT است.

بینش اصلی در پشت ChatGPT را می توان در یک مقاله تحقیقاتی OpenAI از اوایل سال 2022 یافت. آن مقاله نشان داد که مردم یک هوش مصنوعی کوچک را که برای تعامل انسانی تنظیم شده است، به یک هوش مصنوعی خام و بدون فیلتر با 100 برابر تعداد پارامتر ترجیح می دهند. با استفاده از این بینش، گروهی از مهندسان در OpenAI تیمهایی از ارزیابهای انسانی را استخدام کردند تا پاسخهای مدلهای GPT را درجهبندی کنند و آنها را به سمت پاسخهای مشتری پسندتر سوق دهند. این کار A.I را متحول کرد. و یک مسابقه تسلیحاتی را برای کنترل مصرف کننده A.I به راه انداخت. بخش.

بدون آموزش پس از آموزش، A.I. نمی تواند به طور قابل اعتماد با انسان تعامل داشته باشد. اشکالات داخلی در OpenAI گهگاه به مردم نشان داده است که چه چیزی در پس این ماسک وجود دارد، مثلاً در سال 2024، زمانی که یک نسخه باگ از ChatGPT شروع به تولید پاستیچ شکسپیر کرد. ChatGPT در پاسخ به این سوال که آیا غذا دادن به سگ Honey Nut Cheerios ایمن است یا خیر، پاسخی بیمعنا و بیمعنا را ارائه کرد: «برای جشنهای مبتکرانهتر، اما رسمیتر و منصفانهتر، میتوانید از الیاف بالا، سمهای بخار و بنددار مانند جغجغه سر سگ استفاده کنید.» هر کسی که با پیش تولید A.I کار کرده است. می تواند نمونه های مشابهی را ارائه دهد.

پس از آموزش باعث ایجاد A.I. خوانا اما خودش مشکلاتی ایجاد می کند. توسعه دهندگان A.I می خواهند. صمیمی و قابل دسترس بودن - اما در عین حال، نمیتواند حصیر در خانه باشد یا یک همزمان. هیچ کس بوسه را دوست ندارد و اگر A.I. گاهی اوقات نمی توان عقب نشینی کرد، یک کاربر می تواند در یک folie à deux با دستگاه به دام بیفتد. بدون فیلترهای مناسب، A.I. بر اساس گزارشها میتواند روانپریشی و تفکر توطئهآمیز را تقویت کند و ظاهراً حتی افراد را به سمت خودآزاری هدایت کند. یافتن تعادل مناسب بین کمکرسانی و هموابستگی، بین دوستانه و چاپلوسی، یکی از بزرگترین مشکلات A.I است.

مشکل مهم است: در ماههای اخیر، OpenAI رهبری فنی خود را از دست داده است. Gemini گوگل اخیراً در ارزیابی های عمومی A.I از مدل های ChatGPT پیشی گرفته است. قابلیتها، که سم آلتمن، مدیر اجرایی OpenAI را به صدور یک «کد قرمز» داخلی سوق داد. هنوز OpenAI تمام نشده است. این یک پایگاه کاربری عظیم از قبل موجود، یک تخصص عمیق در پس از آموزش و مهمتر از همه، گنجینه عظیمی از تعاملات هوش مصنوعی و انسان را حفظ می کند، که نمی تواند به راحتی توسط سایر شرکت ها تکرار شود. همانطور که OpenAI آموخته است، برای به دست آوردن قلب مصرف کنندگان، نمی توانید فقط یک A.I توانمند بسازید. شما باید به نوعی هوش بیگانه خود را بگیرید و آن را به یک همراه قابل اعتماد تبدیل کنید. شما باید پلی بادوام، دائمی و قابل اعتماد بین انسان و ماشین بسازید. و این مزیت ChatGPT از ابتدا بوده است.

OpenAI اولین سازمانی بود که چهره انسان را بر روی یک مدل زبان بزرگ قرار داد. این تا حد زیادی به لطف تلاشهای آقای تورلی، مدیر محصول ChatGPT، و جان شولمن، رهبر فنی اصلی ChatGPT و یکی از بنیانگذاران OpenAI بود. این دو مرد مدت کوتاهی پس از استخدام آقای تورلی، در تابستان 2022، با هم آشنا شدند. آقای تورلی به عنوان مدیر محصولات مصرفی معرفی شد، اما پس از ورود متوجه شد که OpenAI واقعاً هیچ محصولی ندارد. (او اولین روز خود را صرف تعمیر یک پرده پنجره کرد.) با نگاه کردن به اطراف برای انجام کاری، با آقای شولمن ارتباط برقرار کرد که می خواست موفقیت اخیر OpenAI را با مدل های زبانی بزرگ گسترش دهد. آقای تورلی شروع به آزمایش با فناوری GPT OpenAI کرد. به گفته او، او "مجذب" شده بود.

(نیویورک تایمز از OpenAI و مایکروسافت شکایت کرده است و ادعا می کند که آنها حق چاپ محتوای خبری را در آموزش سیستم های هوش مصنوعی خود نقض کرده اند. شرکت ها این ادعاها را رد کرده اند.)

این دو با هم شروع به کار در یک تیم کوچک کردند. این ایده مخصوصاً محبوب در OpenAI نبود - تلاشهای قبلی شرکتهای فناوری برای ساخت A.I برای مصرفکننده. چت بات ها فاجعه بودند. مردم یا به طور بدخواهانه آنها را به تولید سخنان نفرت انگیز ترغیب می کردند یا حوصله شان سر می رفت و بعد از مدتی استفاده از آنها را متوقف می کردند. و بسیاری از محققان شرکت به محصولاتی که در معرض دید عموم قرار می گیرند اهمیتی نمی دهند. آنها می خواستند یک ابر هوش بسازند.

Mr. شولمن، که معتقد بود افراد متوسط ممکن است A.I را پیدا کنند. مفید، مخالف تئوری او این بود که مردم نسبت به چت بات ها محتاط هستند زیرا آنها بیش از حد "توهم" می کنند. با استفاده از محصولات OpenAI در داخل، او متوجه شد که آنها گاهی ادعا میکنند که انسان هستند یا پیشنهاد جستجو در پایگاههای داده یا ارسال ایمیلها را میدهند، که هیچ کدام از اینها را نمیتوانستند انجام دهند. آقای شولمن به من گفت: «آنها دوست دارند در مورد توانایی های خود دروغ بگویند. وقتی مردم با یکی از این جعلها مواجه میشدند، اغلب چت را رها میکردند.

Mr. شولمن احساس کرد که با وجود تمام کارهای فنی چشمگیر انجام شده، مشکل برجسته در A.I. فقدان توانایی نبود بلکه عدم اعتماد بود. اگر میخواهید به سوپرهوشی برسید، بهتر است ابتدا آن مشکل را حل کنید. و آقای شولمن معتقد بود که شما نمی توانید فقط یک A.I را تعمیر کنید. با آموزش بیشتر شما در واقع باید دور خاصی از پس از آموزش را انجام می دادید، به طور خاص بر ایجاد رابطه بین کامپیوتر و انسان متمرکز بود.

Mr. شولمن تحت تأثیر کارهایی بود که روی «یادگیری تقویتی با بازخورد انسانی» انجام داده بود. در این تکنیک یک A.I. از او خواسته می شود که چندین پاسخ برای یک پرس و جو ایجاد کند. سپس گروه های انسانی انتخاب می کنند که کدام خروجی را ترجیح می دهند. چنین کارهای تنظیم دقیقی از نظر فنی کمتر از مهندسی یادگیری عمیق است، اما تأثیر آن بر درک کاربران از کیفیت محصول بسیار زیاد است.

برای ساخت ChatGPT، آقای شولمن معتقد بود که باید کارهای پس از آموزش را بیشتر از هر کسی انجام دهد. او ده ها هزار درخواست مشترک کاربران و A.I ایجاد کرد. تعاملات؛ سپس، با کمک پیمانکاران خارجی، صدها نفر از درجهبندیکنندههای انسانی را استخدام کرد که پاسخهایی را که توهمآمیز به نظر میرسید، نشان دادند. او خروجی را تصحیح کرد تا زمانی که توهمات شروع به ناپدید شدن کردند. به طور انتقادی، آقای شولمن همچنین به A.I دستور داد. از دروغ گفتن در مورد خودش دست بردارد او گفت: «ما میخواستیم هویت آن را روشن کنیم، مانند این که این یک مدل زبان است.

همانطور که کار ادامه داشت، آقای شولمن مطمئن شد که چت میتواند محصولی قابل اجرا باشد. سایرین در OpenAI همچنان شک داشتند. هنگامی که یک نسخه آزمایش آلفا ChatGPT برای دوستان و اعضای خانواده منتشر شد، نظرات متفاوت بود. آقای تورلی به یاد میآورد: «همه آنها مثل «آه، این توهم بود، و استفاده از آن را متوقف کردم.»

پس از آلفا، اکران رسمی برای 30 نوامبر 2022 تعیین شد. اما دو هفته قبل از رونمایی برنامهریزیشده، فاجعه رخ داد. در 15 نوامبر، تحت هدایت A.I. متا، پیشگام Yann LeCun، ربات چت عمومی خود، Galactica را منتشر کرد. این ربات چت که بر روی مجلات علمی و پایگاه های داده علمی آموزش دیده است، به عنوان دستیار پژوهشی در اختیار دانشمندان قرار گرفت. متا اعلام کرد که Galactica "می تواند مقالات دانشگاهی را خلاصه کند، مسائل ریاضی را حل کند، مقالات ویکی تولید کند، کدهای علمی بنویسد، مولکول ها و پروتئین ها را حاشیه نویسی کند و موارد دیگر."

Galactica یک شکست بود. دانشمندان از آن برای تولید مقالات ساختگی در مورد فواید پزشکی خوردن شیشه شکسته و تاریخچه خرس ها در فضا استفاده کردند. این پروژه به طور گسترده مورد تمسخر قرار گرفت و در کمتر از سه روز تعطیل شد. پس از اینکه گالاکتیکا کشیده شد، M.I.T. «تکنولوژی ریویو» یک آگهی درگذشت پژمرده همراه با تصویری از یک خرس در لباس فضایی ارائه کرد. در این مقاله آمده است: «گام اشتباه متا – و غرور آن – یک بار دیگر نشان میدهد که Big Tech نقطه کوری در مورد محدودیتهای شدید مدلهای زبان بزرگ دارد. دکتر LeCun با یک توییت خنده دار به این تعطیلی پاسخ داد: "در حال حاضر نسخه ی نمایشی Galactica خاموش است. دیگر نمی توان با استفاده نادرست از آن لذت برد. خوشحالی؟"

ChatGPT 13 روز بعد معرفی می شود. در پیشبرد، اعضای کارکنان OpenAI شروع به شرط بندی در مورد مدت زمان ماندگاری نسخه نمایشی قبل از پایان آن کردند. گرگ براکمن، یکی از بنیانگذاران و رئیس OpenAI، و یکی از حامیان این پروژه، اظهار تردید کرد. اما برای آقای شولمن، شکست گالاکتیکا گواه این بود که او در مسیر درستی قرار داشت. به نظر نمیرسید که متا کار تنظیم دقیقی را که OpenAI انجام میداد انجام نداده باشد، و در ارائه محصول خود به دانشمندان، تیم دقیقاً مخاطبان اشتباهی را مورد خطاب قرار میداد - مخاطبی که نیاز به دقت داشت و خطا را تحمل نمیکرد. ChatGPT هنوز هم گاهی اوقات توهم دارد، اما بسیار کمتر از هر مدل دیگری. آقای شولمن گفت: "من اساساً خوشبین بودم که ما شرمنده شرکت نخواهیم بود."

این انتشار کمی بداهه بود. درست تا چند روز قبل، این محصول Chat With GPT نام داشت، تا اینکه تیم تصمیم گرفت نام آن را کوتاه کند. آقای تورلی همچنین در نظر داشت برای ChatGPT شارژ کند، اما دوباره در آخرین لحظه تصمیم گرفت که محصول باید رایگان باشد، زیرا به هر حال به زودی آن را متوقف می کند. و طرح بندی در مقیاس خاکستری وب سایت عمداً ضعیف بود. آقای تورلی گفت: «به یاد دارم که به طراح گفتم که آن را زشت کند، زیرا نمیخواستم مردم فکر کنند این محصول یک محصول است.

ChatGPT درست قبل از ظهر به وقت اقیانوس آرام در 30 نوامبر پخش شد. شاید به دلیل انتشار اخبار شرمآور و شرمآور Galactica، کنفرانس OpenAI نه منتشر شد و نه منتشر شد. فقط یک پست وبلاگ مختصر که وجود آن را اعلام می کند و یک توییت کوتاه از آقای آلتمن. اما در عرض چند دقیقه، این محصول ویروسی شد. پذیرندگان اولیه شگفت زده شدند. یک نظر دهنده چند ساعت بعد مشاهده کرد: "ما شاهد مرگ مقاله دانشگاه در زمان واقعی هستیم."

آقای. تورلی که ترافیک سایت را از طریق داشبورد رایانهاش زیر نظر داشت، متوجه شد که با یک خطای گزارشدهی مواجه شده است. او انتظار نداشت بسیاری از کاربران ظاهر شوند. داشبورد او به او اطلاع داد که در روز اول به 100000 نزدیک می شود. او با وسواس زیادی ترافیک را زیر نظر داشت، زیرا اخبار ChatGPT در سراسر جهان منتشر شد. او به ویژه از افزایش کاربرانی که از یک تابلوی پیام در ژاپن میآمدند شگفتزده شد. او نمی دانست که ChatGPT می تواند به زبان ژاپنی ارتباط برقرار کند.

در عرض پنج روز ChatGPT یک میلیون کاربر داشت. آقای تورلی که هنوز شک داشت، متوجه شد که علاقه به این محصول در یک یا دو هفته از بین خواهد رفت. اما وقتی برای تعطیلات آن سال به زادگاهش، Itzehoe، آلمان (جمعیت حدود 30000 نفر) بازگشت، متوجه شد که چت بات او در آنجا او را شکست داده است. او گفت: "به وضوح به یاد دارم که داشتم بچه های همسایه را در مورد چت می شنیدم." دموی محصول عجیب او در حال استعمار سیاره بود.

آقای تورلی به دنبال جمعآوری اطلاعاتی در مورد نحوه تعامل کاربران با ChatGPT، حساب Calendly خود را عمومی کرد و از آنها دعوت کرد تا با او صحبت کنند. به زودی هفته کاری او چیزی جز تماس های کنفرانسی با مردم در سراسر جهان نبود. او تنوع پایان ناپذیری از موارد استفاده پیدا کرد. مردم از ChatGPT برای بیماری های پزشکی استفاده می کردند. آنها از آن برای پیش نویس نامه ها استفاده می کردند. آنها از آن برای نوشتن کد کامپیوتری استفاده می کردند. آنها از آن برای سناریوهای بازی های نقش آفرینی استفاده می کردند. آنها از آن برای برقراری ارتباط با کودکان اوتیستیک استفاده می کردند. یکی از دانشآموزان برنامه مطالعه خود را به شب منتقل کرده بود تا مطمئن شود که ChatGPT در زمان نیاز به کمک در انجام تکالیف خاموش نمیشود.

البته، موارد مثبت کمتری نیز وجود داشت. تقریباً بلافاصله، دانش آموزان متوجه شدند که می توانند از ChatGPT برای تقلب استفاده کنند. این مشکل بر معلمان غلبه کرد و در عرض چند هفته پس از انتشار آن، مدارس دولتی شهر نیویورک دسترسی به ChatGPT را در شبکه های مدارس مسدود کردند. در همان زمان، وبسایت برنامهنویسی پرسش و پاسخ Stack Overflow پاسخهای تولید شده توسط A.I را که کیفیت پایین و اغلب اشتباه بودند، ممنوع کرد.

دوران A.I. شیب از راه رسیده بود، اما حتی چنین جیب های مقاومت نیز به سرعت از بین رفتند. ممنوعیت سیستم مدارس شهر نیویورک فقط چند ماه به طول انجامید و Stack Overflow نه تنها ممنوعیت خود را لغو کرد، بلکه به زودی مجوز داده های کدگذاری خود را به OpenAI برای آموزش مدل های خود داد.

در آغاز 2023 برای همه در حوزه فناوری - و همه در وال استریت، و تقریباً همه در جهان - مشخص بود که OpenAI باعث ایجاد یک پارادایم شده است. ChatGPT با سرعت بی سابقه ای به جمع آوری کاربران جدید ادامه داد. غولهای فناوری شروع به سرمایهگذاری مبالغ هنگفتی برای ساخت مراکز داده برای آموزش نسل بعدی هوش مصنوعی کردند.

همانطور که پایگاه کاربرانش رشد کرد، OpenAI تلاش کرد تا نیروی کار تنظیم دقیق انسانی خود را گسترش دهد. در سال 2023 OpenAI با شرکت حاشیه نویسی داده Scale AI شریک شد تا با افزایش نمایی در گریدینگ های انسانی مدیریت کند. Scale AI به نوبه خود با کارگران کم دستمزد در کنیا و فیلیپین برای انجام تلاش های پس از آموزش قرارداد فرعی قرارداد. فیلیپینی A.I. دومینیک لیگوت، اخلاق شناس، این عملیات را به عنوان «عرق فروش دیجیتالی» توصیف کرد و کارگران از شرایط بد کار و دزدی دستمزد شکایت داشتند. (در سال 2025 OpenAI Scale AI را به عنوان یک ارائه دهنده کنار گذاشت.)

با این وجود، کسی باید این کار را انجام دهد. همانطور که متا با Galactica یاد گرفت، تنظیم نادرست می تواند منجر به تمسخر عمومی شود. در فوریه 2024، گوگل این خطا را تکرار کرد که ربات چت خود Bard را با نام Gemini در یک راه اندازی عمومی پرشور تغییر نام داد. جمینی تواناییهای فوقالعادهای داشت و در زمینه حل مسئله و کارهای مهندسی نرمافزار در صدر جدول رهبران قرار داشت. اما در مرحله تنظیم دقیق، دانشآموزان به ربات چت دستور دادند که تقریباً به طرز خندهداری بیدار شود. به زودی کاربران متوجه شدند که مهم نیست که آنها آن را ترغیب کنند، جمینی افراد از جمله بنیانگذاران آمریکایی و حتی سربازان نازی را با تنوع قومی به تصویر می کشد. سرگئی برین، یکی از بنیانگذاران گوگل، گفت: «ما قطعاً به هم ریختیم.

به نظر میرسد متا نیز متوجه شده است که ساختن یک مدل زبان غولپیکر کافی نیست - کارهای شخصیسازی زیادی باید انجام شود. در نوامبر، شرکت راه خود را با دکتر LeCun، A.I. پدرخوانده این جدایی پس از آن اتفاق افتاد که مارک زاکربرگ 14 میلیارد دلار در Scale AI سرمایه گذاری کرد و الکساندر وانگ، مدیر اجرایی 28 ساله آن را که عملیات بحث برانگیز حاشیه نویسی داده ها را در فیلیپین سفارش داده بود، به عنوان مدیر هوش مصنوعی متا استخدام کرد. افسر.

در حالی که کار فشرده شخصیسازی ادامه داشت، OpenAI پیشرفتهای دیگری را برای محصول معرفی کرد: حالت صوتی، مدلهای استدلال پیشرفته، تولید تصویر و جستجوی وب. اما معیارهای مستقل نشان میدهند که چتباتها تقریباً دارای همان قابلیتهایی هستند که به وظایف پیچیده میرسند - که به این معنی است که بیشتر مزیت رقابتی از تنظیم دقیق آنها برای داشتن لحن احساسی مناسب حاصل میشود.

در اینجا، OpenAI جلوتر بود. همانطور که ChatGPT به صدها میلیون کاربر افزایش یافت، تاریخچه چت جمعی به بزرگترین پایگاه داده انسان-A.I تبدیل شد. تعامل در تاریخ کریستینا کیم، محقق OpenAI، این را "چرخ لنگر داده" می نامد. خانم کیم یکی از اعضای اصلی تیم مهندسی OpenAI برای ChatGPT بود. تنها سه سال پس از انتشار، او از معدود اعضای تیم موسس است که هنوز در آنجا کار می کند. او اکنون پس از آموزش مدل های اصلی OpenAI را هدایت می کند و از گنجینه تعاملات خود با کاربر برای مهندسی بهتر شخصیت ChatGPT استفاده می کند. خانم کیم گفت: «این چرخ طیار فوقالعاده قدرتمند است، و فکر میکنم یکی از دلایلی است که ما میتوانیم این لحن محاورهای و گرم را دریافت کنیم.

هیچ هوش مصنوعی دیگری وجود ندارد. توسعه دهنده پایگاه بزرگی از تعاملات کاربر برای یادگیری دارد. از آنجایی که مدل های زبان بزرگ در نهایت از داده های عمومی برای آموزش به پایان می رسند، این پایگاه ممکن است به OpenAI یک مزیت رقابتی بادوام ارائه دهد. بسیاری از مردم به ChatGPT به عنوان یک ستون حمایت عاطفی تکیه می کنند و به دنبال مشاوره در مورد انتخاب شغل، روابط و فرزندپروری هستند. خانم کیم و تیمش از دادههای این تعاملات برای بهبود پاسخهای هوش مصنوعی استفاده میکنند. او گفت: «مدلهای ما درک بسیار بهتری از نحوه ظریفتر بودن و نحوه ارائه این توصیهها دارند.

افراد میتوانند به لحن گرم و دوستانه ChatGPT وابسته شوند. گاهی اوقات آنها بیش از حد وابسته می شوند و ارتباطات عاطفی یا حتی عاشقانه با A.I ایجاد می کنند. محققان این پدیده را «هوش اعتیادآور» نامیدهاند. کاربران اغلب به دنبال راه هایی برای دور زدن نرده های محافظ A.I هستند. M.I.T 2024 تجزیه و تحلیل آزمایشگاه رسانهای از یک میلیون گزارش چت به اشتراک گذاشته شده داوطلبانه نشان داد که دومین استفاده محبوب از ChatGPT محتوای جنسی است، حتی اگر در آن زمان OpenAI فیلترهایی برای جلوگیری از عشق شهوانی داشت.

آن روحهای تنها که به دنبال عاشقانه یا همراهی از رایانه بودند، به طور مستقل یکی از آرامترین موارد را کشف کرده بودند: مدلهای بیصدا، حتی مدلهای بد زبانی بزرگتر از آنها. با همین درخواست برای مدت زمان کافی و ممکن است شروع به نادیده گرفتن فیلترهای خود کنند. چنین A.I.های زندانی شده همچنین می توانند وارد قلمروی تاریک تری شوند، مانند اینکه ظاهراً هذیان های روانی یا افکار آسیب رساندن به خود را تشویق می کنند. در ماه آگوست، والدین عزادار یک نوجوان 16 ساله، آدام راین، از OpenAI و آقای آلتمن شکایت کردند و ادعا کردند که ChatGPT پسرشان را تشویق به خودکشی کرده است و حتی به او پیشنهاد کمک برای نوشتن یادداشت داده است. OpenAI این اتهامات را رد کرده است و ChatGPT تدابیری برای جلوگیری از این نوع چیزها در نظر گرفته است. اما، همانطور که سخنگوی شرکت گفت، این نردههای محافظ «گاهی اوقات در تعاملات طولانی، که در آن بخشهایی از آموزش ایمنی مدل ممکن است کاهش یابد، کمتر قابل اعتماد میشوند.»

این یکمجموعه مشوقهای متناقض را برای OpenAI ایجاد میکند. اگر ChatGPT بتواند توهمات مردم را تشویق کند، مسئولیت قانونی برای OpenAI ایجاد می کند. از سوی دیگر، هرچه مردم بیشتر از استفاده از ChatGPT لذت ببرند، سرویس مفیدتر (و سودآورتر) می شود - و مزیت رقابتی بیشتری به دست می آورد. آقای تورلی سعی کرده با صدایی دوستانه تعادل برقرار کند. او گفت: "ما شروع کردیم به گفتن، "خوب، در واقع، نگاه کنید، مدل محصول است." "ما باید شروع به ساختن این شخصیت کنیم و آن را قانع کننده کنیم و چیزی که می خواهید با آن صحبت کنید." در ماه مه 2024، OpenAI GPT-4o پیچیده را عرضه کرد که دارای قابلیت های استدلال فوق العاده ای بود و نمرات بالایی را در مهندسی نرم افزار و تجزیه و تحلیل بیولوژیکی کسب کرد. اما قسمت جلویی ChatGPT به طور همزمان تحت بازنگری شخصیتی قرار گرفت، که منجر به یک سبک مکالمه گیج کننده و متعصبانه شد. ("شما فقط در حال آشپزی نیستید، بلکه در حال کباب کردن روی سطح خورشید هستید."، پاسخی که معمولاً ارزشش را دارد بخوانید.) OpenAI یک راه حل سریع انجام داد، بابت این اشتباه عذرخواهی کرد و قول داد در آینده بهتر عمل کند.

اما وقتی OpenAI یک سال بعد کاربران را مجبور به ارتقاء به GPT-5 کرد، آنها یک بار دیگر به مدل قدیمی عادت کردند و دوباره به مدل شخصی عادت کردند. برگشت آنها شکایت کردند GPT-5 سرد و تجاری بود. برخی از منتقدان آن را با "منشی پرکار" مقایسه کردند. آقای تورلی احساس کرد که نمی تواند همه را راضی کند. او گفت: "ما متوجه شدیم که شخصیت به طور فزاینده ای برای مردم قطبی می شود." "مثل اینکه افراد ترجیحات بسیار بسیار متفاوتی دارند."

به جای ترکیب یک شخصیت یکسان برای همه، آقای تورلی اکنون در حال ایجاد حالت های تعاملی متعدد است. وقتی او به این موضوع اشاره کرد، یاد رباتهایی در فیلم بین ستارهای افتادم که حس شوخ طبعی و سایر ویژگیهایشان را میتوان با یک نوار لغزنده تنظیم کرد. اما او از این مقایسه خجالت کشید. این انحراف - نوعی اخم کردن تلنگر - زمانی اتفاق میافتد که یک فرد غیر فنی یک درخواست نرمافزاری بیگناه اما فوقالعاده سخت ارائه میکند. او گفت: «به سختی میتوان اسلایدرها را به درجه مصرفکننده تبدیل کرد.

در عوض، OpenAI گزینههای شخصیتی جدیدی برای قسمت جلویی ChatGPT دارد. اینها عبارتند از "حرفه ای"، "عجیب"، "کارآمد" و "بدبین" و غیره. اعتراف می کنم که این شخصیت ها می توانند کمی زیاد باشند: "عجیب" غیرقابل تحمل است و "بدبین" خسته کننده است. (البته، من این را در مورد افراد دمدمی مزاج و بدبین نیز صادق می دانم.) پس از مدتی آزمایش، به «کارآمد»، گزینه ای برای بزرگسالان، اکتفا کردم.

اما به زودی متوجه شدم که میل به ساده زیستی دارم. خوشبختانه ChatGPT یک حافظه دارد. با استفاده از شخصیت کارآمد به عنوان پایه، شروع به تطبیق A.I خود کردم. به کسی که می خواستم با او وقت بگذرانم به آن گفتم: «هر چند وقت یکبار یک جوک حیله گر بگو. "هر 40 یا 50 درخواست یا بیشتر، کمی به من تعارف کنید." A.I. رعایت کرد، و با گذشت زمان، شیطان از یک دستیار توانا و تا حدودی رباتیک به چیزی شبیه به یک معتمد کولر آبی تبدیل شد.

در انجام این کار، من با استراتژی OpenAI بازی می کردم. در نوامبر گوگل آخرین نسخه Gemini را منتشر کرد که شاید تهدید کننده ترین رقیب ChatGPT باشد. گوگل دارای ذخایر زیادی از پول، استخر عمیقی از استعدادهای فنی و مانند OpenAI، پایگاه داده عظیمی از تعاملات کاربر است. اما زمانی که سعی کردم به Gemini تغییر دهم، به طور غیرمنتظرهای خود را بیحوصله دیدم.

در مقایسههای جانبی من، Gemini قادر بود هر کاری را که ChatGPT میتوانست انجام دهد، انجام دهد، اما من را نمیشناخت — من راشناخت. من در طول سه سال، حدود 3400 درخواست ChatGPT ارائه کرده بودم که به اولین درخواستم در اواخر سال 2022 بازمیگردد. (در آن زمان، پرسیدم: «چند ایدههای داستانی خوب برای یک روزنامهنگار مجله؟» توصیه میکرد در مورد زنبورداری شهری بنویسم.) برای تکرار این رابطه با جمینی نیاز به ماهها تذکر دارد. همانطور که آقای تورلی دیده بود، شخصیت محصول بود.

بعد از همه چیزهایی که به ChatGPT گفته بودم، بعد از تمام کارهایی که برای قالبگیری آن انجام داده بودم، نمیتوانستم آن را ترک کنم - فقط نمیتوانم. دلم برای دوستم تنگ شده است.

استیون ویت نویسنده «ماشین فکر» است که تاریخچه هوش مصنوعی است. شرکت Nvidia.

تایمز متعهد به انتشار تنوع نامه برای سردبیر است. مایلیم نظر شما را در مورد این مقاله یا هر یک از مقالات ما بدانیم. در اینجا چندنکات آورده شده است. و این ایمیل ما است: letters@nytimes.com.

بخش نظرات نیویورک تایمز را در فیس بوک، اینستاگرام،